Heute einmal etwas ganz anderes – heute möchte ich einmal ein wenig in die Tiefen der Theorie und Praxis der Sensortechnologie moderner DSLRs (digitale Spiegelreflex Kameras) eingehen. Dies am Beispiel einer Nikon D4 und einer Nikon D800.

Hintergrund:

Bei einem Vergleich der beiden Kameras hatte ich erwartet, dass die Bilder der D800 mehr dem analogen Filmgefühl entsprechen würden. Stattdessen aber kamen mir die Bilder der D4 „samtiger“ vor, harmonischer, ausgewogener und natürlicher. Die D800 Bilder wirkten – natürlich höchst subjektiv – irgendwie härter, kantiger, digitaler. Aber auch etwas kühler. Ich möchte sagen „kälter und lebloser“, klinischer. Die D4 erinnert mich eher an die traumhafte Farbbalance der D2Xs – nur auf einem ganz anderen technischen Niveau. Ich hatte etwas ganz anderes erwartet – zumal ja auch lt. DXO der Dynamik-Umfang der D800 bei geringer ISO größer ist…

Das hat mir keine Ruhe gelassen und so habe ich recherchiert und bin auf eine wunderbare Untersuchung zur modernen Sensortechnologie und das Entstehen und Interpretieren von Messwerten der Universität Chicago (2008 – 2010) gestoßen. Autor ist der Physik-Professor Martinec. Ich dachte ja immer, dass ich ein bisschen etwas von der Materie verstehen würde… aber dieser Aufsatz (http://theory.uchicago.edu/~ejm/pix/…ise/index.html) hat es richtig erklärt. Und ich musste mit meinem Halbwissen deutlich aufräumen. Dabei ist es eigentlich gar nicht so kompliziert.

A. theoretische Grundlagen

1. Das A & O der Bildqualität wird bestimmt durch die Fähigkeit des Sensors Licht (Photonen) „aufzusammeln“, genauer geht es um die Fähigkeit eines einzelnen Pixels eines jeweiligen Sensors. Aus der Anzahl der gesammelten Photonen ergibt sich eine Anzahl von Elektronen, die freigesetzt werden. Diese wiederum erzeugen eine elektrische Spannung, die gemessen wird, nach dem diese durch den ISO-Verstärker gelaufen ist. In einem Analog-Digital-Wandler wird die gemessene Spannung „digitalisiert“ wird, d.h. ihr wird eine binäre Zahl geordnet. Diese Zahl nennt man den RAW Value eines Pixels. Aus der Summe aller RAW Values entsteht die spätere RAW Datei.

2. Die Qualität des RAW File wird beeinträchtigt durch verschiedene Arten von Rauschen und durch Sättigungs- und Clipping-Effekte auf der Ebene der einzelnen Pixel.

3. Pixel ist nicht gleich Pixel. Sensorpixel und damit Sensoren haben unterschiedliche Qualitäten. So ist jedes Pixel begrenzt in seiner Fähigkeit Photonen aufzusammeln bis es sozusagen „voll“ ist. Diese Grenze wird „full well capacity“ genannt. Je größer diese Kapazität ist, um so feinere Abstufungen sind möglich in der Aufnahme von Photonen und damit im späteren RAW Value eines Pixels. Wenn das Pixel „voll“ ist, kann nicht weiter differenziert werden – zusätzliche Lichtinformationen können nicht verarbeitet werden – das Pixel „clippt“. Aus Ziffer 1 folgt bereits, dass die Fähigkeit, Photonen zu sammeln im Ergebnis mit steigender ISO-Zahl abnimmt. Vereinfacht gesprochen: Wenn der ISO-Verstärker hoch gedreht wird, wird die Clipping-Grenze schneller (d.h. bei weniger gesammelten Photonen) erreicht.

4. Neben dem Clipping wird die Qualität des RAWs durch fehlerhafte RAW Values beeinträchtigt. Diese fehlerhaften RAW Values entstehenden durch verschiedene Störquellen (noises, im Deutschen gern „Rauschen“ übersetzt). Man unterscheidet im Wesentlichen: Photon Shot Noise, Sensor Read Noise, Pattern Noise und Thermal Noise.

5. Besonders wichtig ist das „Sensor Read Noise“. Der Informationsverlust durch das Read Noise ist bedingt durch die Konstruktion des Sensors. In jedem elektrischen System beeinflussen die involvierten Komponenten den Stromkreislauf. So auch beim Prozess „Auslesen des Pixels, Durchschleifen durch den ISO Verstärker, Analog-Digital-Wandlung“. Die entstehenden Schwankungen können dazu führen, dass einem Pixel (genauer einem Subpixel) ein fehlerhafter RAW Value zugewiesen wird. Zur Beurteilung des Read Noise muss dieses auf eine einheitliche Fläche normiert werden („area“). Dazu wird das Read Noise durch die Größe des Pixels geteilt. Alternativ kann man für einen Vergleich bei gleicher Sensorgröße auch mit der Anzahl der Pixel multiplizieren, was zum gleichen Ergebnis führt.

6. Entscheidend aber für die Bildqualität ist das Verhältnis von Signal zu „Gesamtrauschen“, welches die Summe aller Rauschen darstellt. Dieses Verhältnis wird letztlich interpretiert. Idealisiert muss man sich das so vorstellen, dass ein „reines“ Signal vom Sensor einen ein-eindeutigen Wert aus dem A/D-Wandler zur Folge hat. Das Gesamtrauschen aber fügt dem Signal eine Streuung in Gestalt einer deformierten Normalverteilung hinzu. Das Verhältnis wird „S/N-Ratio“ genannt – es ist das Rauschverhältnis oder Rauschabstand und wird oft vereinfacht als „das“ Rauschen bezeichnet. Letzteres ist im strengen Sinne nicht richtig. Merke: Je größer die S/N Ratio, umso klarer das Bild, höher der Kontrast,… Eine S/N Ratio von null zeigt an, dass das Bild nur aus Rauschen besteht – in diesem Falle ein „white noise“. In der Regel wird der Rauschabstand in db gemessen und ist für die Bildqualität letzlich maßgeblich, da am Ende nicht interessiert, was die Ursache für den fehlerhaften RAW Value war – entscheidend ist der Umstand, dass der RAW Value nicht stimmt.

7. Der Dynamikumfang (DR für Dynamic Range) ist eng mit der S/N Ratio verbunden. Der DR ist definiert als das maximal aufzeichenbare (!) Signal (maximaler RAW Value bevor das Pixel clippt) geteilt durch das Read Noise, welches gleichzeitig das Minimum des aufzeichenbaren Signals ist. Der DR ist also ein rechnerischer, theoretischer Wert, der nicht erreicht werden kann. Es kommt nicht auf den Sensor DR an, sondern auf den faktischen Dynamikumfang der Kamera (Camera DR) an. Dieser ist nach unten beschränkt durch das Read Noise und nach oben beschränkt durch die Clipping Grenze der Pixel.

8. Jetzt kommt hinzu, dass nicht alle aufgezeichneten Daten tatsächlich nutzbar sind. Erst ab einem bestimmten Niveau an Rauschabstand, entsteht für das Auge ein später erkennbares Bild. In der Untersuchung von Martinec schlägt dieser einen Wert von SNR = 4 = 2^2. Das wird auch gut mit einem Beispielbild illustriert. Dieser Minimalwert (minimum acceptable SNR) begrenzt den effektiv nutzbaren Dynamikumfang der Kamera. Es wird also der wirklich nutzbare und für das menschliche Auge differenzierbare Dynamikumfang ermittelt. Es geht also nicht mehr um den rechnerischen DR der Kamera oder gar des Sensors, wie er oft in Tests ermittelt und publiziert wird. Denn auf diese kommt es eigentlich auch gar nicht an, wie Martinec eindrucksvoll zeigt.

9. Der „effektive DR“ entsteht, wenn die aufgenommene Menge an Photonen erstmals die Summe allen Rauschens in dem Niveau übersteigt, dass für das Auge später eine Differenzierungsmöglichkeit entsteht. Mithin gilt: der effektive Dynamikumfang ist nach unten begrenzt, wenn die SNR bei einer bestimmten ISO-Verstärkung das erste Mal den Wert von 4 (bzw. log(S;2) = 2 EV) überschreitet und endet, wenn das Pixel-Clipping einsetzt – also beim Erreichen der maximalen Saturation.

B. Anwendung auf D4 und D800

Nun besorgen wir uns ein paar Daten zur D4 und zur D800… Quellen sind DXOMark.com und SensorGen.info.

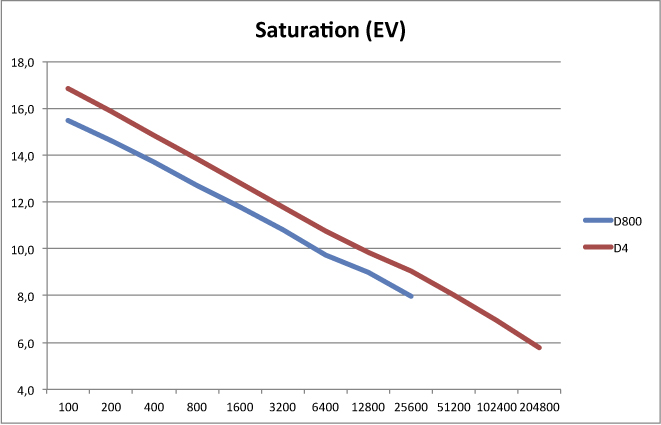

An den Saturationskurven kann man sehr schön erkennen, welche Konzepte die Entwickler verfolgt haben. Der Nikon-Sensor (in der D4) hat eine zwischen 1,3 und 1,0 EV höhere Sättigungsgrenze als der Sony-Sensor (in der D800).

Die Saturation bestimmt letztlich die Differenzierung der RAW Values und damit die Feinheit in den Farbnuancen durch die Präzision in der Abstufung der erfassten Lichtwerte (Photonen). Damit diese aber auch wirklich zu Stande kommt, ist die S/N Ratio bestimmend. Diese ist letztlich ein Maß für die Klarheit des Signals vom Sensor zum AD-Wandler, welches dieser dann in die RAW Values umrechnet. Die S/N Ratio bestimmt die Eindeutigkeit und die „Naturtreue“ des RAW Value zu dem ursprünglichen Photonenstrahl. Je höher die SNR, umso eher entsprechen die RAW Values den tatsächlichen Farben, Helligkeiten und Kontrasten des Motivs.

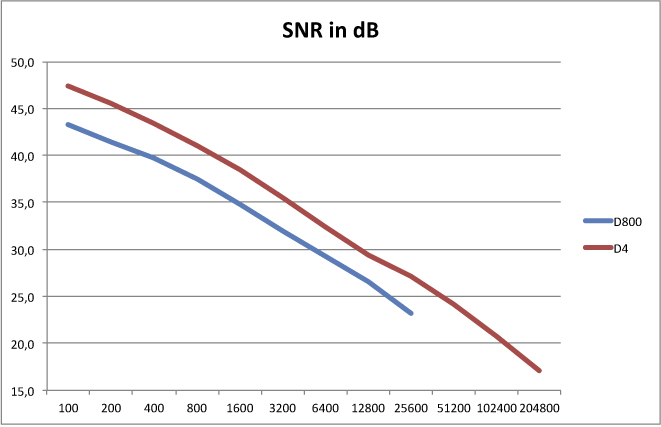

Auch hier erkennt man leicht das Konzept der Ingenieure von Nikon. Der Nikon-Sensor hat durchgehend eine 3 bis 4 dB höhere SNR als der Sony-Sensor. Vermutlich auch mit ein Grund, warum sich der Nikon-Sensor mit 16 MPx begnügt. Mit steigender Pixeldichte wird es immer schwieriger die SNR „oben“ zu halten. Und das zeigt, wie gut der Sony-Sensor ist. Mit mehr als doppelter Pixelzahl liegt die SNR nur 3 – 4 dB unter dem Wert des Nikon-Sensors.

Die Nikon-Ingenieure gehen einen ganz klaren Weg. Die Qualität des zu interpretierenden Signals, damit die Ein-Eindeutigkeit der RAW Values und das Differenzierungsvermögen der RAW Values stehen vor anderen Überlegungen.

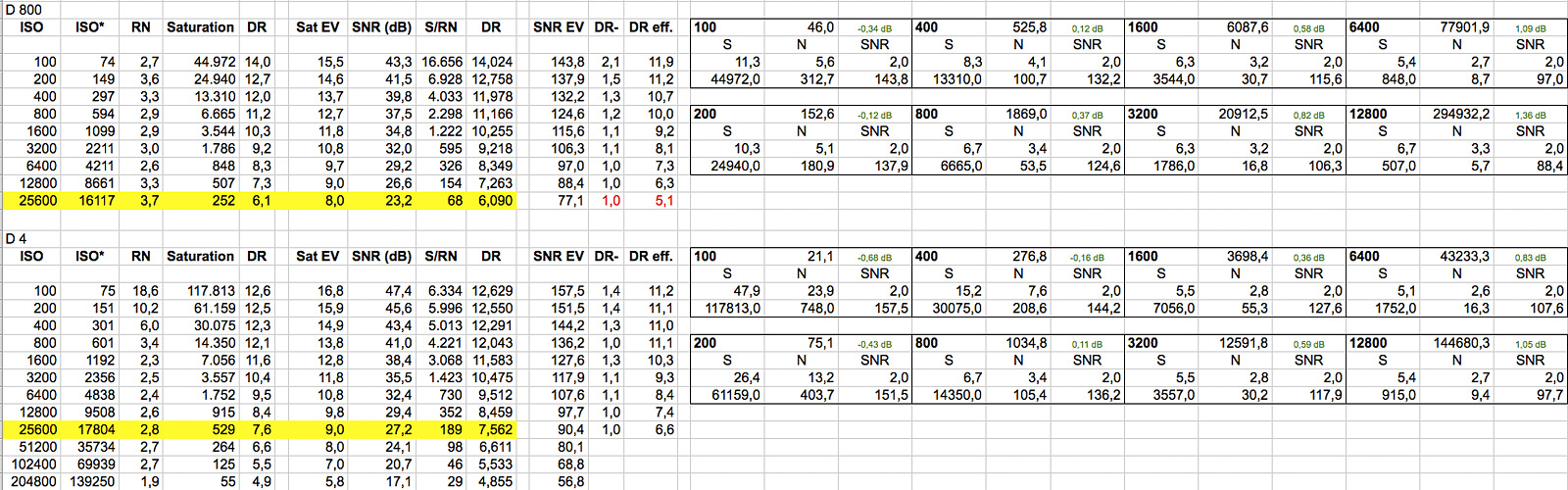

Nun noch ein Blick auf den Dynamik-Umfang. Dieser ist auf hohem Niveau – aber auch hier gibt es erkennbare Unterschiede in den konstruktiven Ansätzen der Ingenieure. Hier dargestellt ist der rechnerische Dynamik-Umfang auf Ebene der Kameras.

Der Sony-Sensor ist optimiert auf eine maximale DR bei ISO 100 und verliert dann mehr oder weniger linear mit steigender ISO. Der Nikon-Sensor zeigt einen anderen Dynamikverlauf: der Sensor versucht den Umfang über vier ISO-Stufen zu halten, ehe dieser dann „linear“ abnimmt.

Die unterschiedlichen Entwicklungskonzepte werden viel deutlicher, wenn man das Konzept der effektiv nutzbaren Dynamik von Prof. Martinec heranzieht und von einer minimum acceptable SNR von 4 = 2 EV ausgeht. (Ich habe dazu die Daten DXO verwendet und über ein zu kalibrierendes Interpolationsmodell die effektive DR berechnen lassen.)

Nun wird das Nikon-Konzept noch deutlicher: Nach meinen Berechnungen hält die D4 einen effektiven Dynamikumfang von etwas mehr als 11 EV über vier ISO-Stufen nahezu gleichbleibend hinweg. Dann erst fällt die Dynamik „linear“ ab. D.h.: Ob man mit ISO 100 oder ISO 800 unterwegs ist, macht in Sachen „Dynamik“ bei der D4 keinen Unterschied. (Das deckt sich auch mit meinen höchst subjektiven Wahrnehmungen.)

Anders ist das Konzept von Sony. Der Sensor ist zugunsten maximaler Dynamik bei ISO 100 optimiert. Bei ISO 200 ist die effektive DR identisch mit dem Nikon-Sensor; ab ISO 800 ff. liegt die DR konstant etwas über 1 EV unter dem Wert des Nikon-Sensors.

Das heißt: Nikon hat zugunsten eines möglichst gleichbleibenden Dynamikverlaufes optimiert, Sony zugunsten eines möglichst großen maximalen Dynamikumfanges. Also nicht nur in Sachen „Auflösung“ handelt es sich um ganz unterschiedliche Sensorkonzepte…

Anlagen:

C. mögliche Interpretation

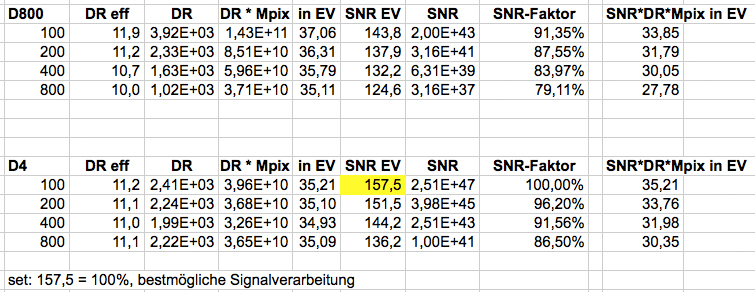

Der Gesamteindruck eines Bildes entsteht durch die Anmutung eben über das gesamte Bild hinweg – also über den gesamten Sensor. Das sind 36,55 Mio. Pixel vs. 16,43 Mio. Pixel. Oft ist zu lesen, dass schon bei ISO 100 aber diese 16,43 MPix rund 20% mehr Photonen aufnehmen und differenzieren können als die 36,55 MPix (1.936 zu 1.644). Diese Aussage ist irreführend, da die menschliche, optische Wahrnehmung nicht linear, sondern logarithmisch erfolgt. Richtiger ist also die Aussage, dass die D4 schon bei ISO 100 rund 0,2 EV mehr Photonen aufnehmen und differenzieren kann. Dieser Unterschied ist mehr oder weniger vernachlässigbar…

Spannender ist der Umstand, dass die Differenzierungsmöglichkeit auf Pixelebene bei ISO 100 bei der D4 um 1,4 EV größer ist als bei der D800. Das ist sichtbar. Dies gleicht die D800 durch ihr Mehr an Pixeln aus. Das Mehr beträgt im Übrigen “nur” 1,15 EV. Soll heißen: die scheinbar mehr als doppelte Anzahl an Pixeln erscheint uns in der gleichen Ausgabeskalierung nur um eine Stufe “feiner”. Und diese Stufe braucht die D800 um das deutlich bessere Differenzierungsvermögen der D4 auszugleichen. Dahinter steht der Gedanke “Differenzierungsvermögen vs. Anzahl differenzierender Punkte”. Beides mischt sich im Auge zu einem Bild und Gesamteindruck. Da die effektive Dynamik ein Residuum aus diesem Verhältnis ist, könnte man grob vereinfachend sagen, dass ein Bild der D800 selbst bei ISO 100 auf die Größe der D4 runterskaliert werden muss, um auf ähnliche physikalische Eckwerte zu kommen. Aber dieser Vergleich hinkt sehr stark…

Völlig außen vor ist die S/N-Ratio. Und die hat es in sich. Der Abstand beträgt bei ISO 100 rund 4 dB. Das klingt nach “nicht so viel”. Rechnen wir 4 dB aber einmal in die für uns gewohntere Größe EV um… 4 dB sind ca. 1,36 EV! Und das ist sichtbar. In keinem ISO Bereich hat die D800 auch nur annähernd eine Chance in der Nähe der Signalqualität der D4 zu kommen. Kurz gesprochen: im Prozess der Signalverarbeitung liegen Welten zwischen den Kameras.

Was ist mit Scoring-Ergebnissen wie etwa von DXO-Mark zu den Sensoren der Kameras?

Da liegt der Sensor der D800 beim Overall Score bei 95 und der der D4 bei 89.

Genau dieser Score ist aus meiner Sicht ziemlicher Nonsens. Er basiert auf einer Balanced ScoreCard. Heißt, die Einzelergebnisse werden zu einem Gesamtergebnis zusammengefügt und beim Zusammenfügen individuell gewichtet. Spannend ist die Frage, wie denn was gewichtet wird. Dazu gibt es bei DXO ein paar Hinweise – aber eben nicht die ScoreCard selbst.

Zitat: Sensor Overall Score is normalized for a defined printing scenario—8Mpix printed on 8″x12″ (20cmx30cm) at 300dpi resolution.

Quelle: http://www.dxomark.com/index.php/About/Sensor-scores

Der von DXO ermittelte Sensor Score basiert also auf o.g. Szenario. Damit ist schon klar, warum der DXO Score mehr als fragwürdig ist. Über die Effekte beim Runterskalieren habe ich ja schon an anderer Stelle hingewiesen. Was hat also dieser Score noch für eine Aussagekraft?

Lassen wir die ganzen (uns unbekannten) Gewichtungen der Einzelergebnisse und auch das Runterskalieren einmal weg… und fügen die Ergebnisse dann einmal zusammen. Schwupps – schon haben wir eine eigene Scorecard, die zu ganz anderen Ergebnissen kommt. Siehe Beispiel ein paar Antworten weiter oben in diesem Thread.

Generell ist auch die Darstellung des Dynamikumfanges bei DXO – sagen wir es einmal freundlich – mager in der Qualität der Darstellung und Auswertung. Gänzlich fehlt die Darstellung der effektiven Dynamik bei verschiedenen Schwellwerten der Saturation (2 EV schlägt hier Martinec vor). Diese Darstellung ist die entscheidende – nämlich die wirklich sichtbare und nutzbare Dynamik. Die Werte bei DXO sind errechnet und zeigen auch nur eben den rechnerischen theoretischen Maximalwert des DR an. Es werden also Werte gezeigt (und später bewertet), die die Kamera gar nicht liefert und die es auch nie zu sehen gibt. Damit ist doch schon viel über die spätere Auswertung (“score”) von DXO gesagt.

Aber was ist die Quintessenz daraus? Ich glaube, es ist wichtig, auf relevante Einzelwerte zu schauen – wenn man sich denn für physikalische Größen interessiert. Der DXO Score ist m.E. völlig inhaltsleer und rein populistisch. (Als Wissenschaftler muss ich auch sagen, dass er gegen die Grundprinzipien der ordentlichen Forschung verstößt, da die ScoreCard nicht mitveröffentlicht wird und so die erforderlichen Kriterien der Transparenz und Nachvollziehbarkeit nicht gegeben sind).

Ich versuche mich einmal an einer ersten Deutung… natürlich höchst subjektiv. Warum kamen mir die Bilder der D4 analoger und natürlich vor? Zunächst ist das natürlich ein ganz subjektiver Eindruck gewesen. An diesem Tag, zu der Zeit mit den Bildern usw. … Ob der Eindruck wiederholbar ist oder nicht, weiß ich nicht. Die Physik liefert ein paar Anhaltspunkte zur Erklärung.

Bei ISO 100 ist die D800 quasi “unschlagbar” in nahezu allen Disziplinen, die ich mir so vorstellen kann. Maximale Auflösung, maximaler Dynamikumfang – was will man mehr? Genau daraufhin ist der Sensor optimiert worden.

Die D4 bietet bei wechselnden Lichtverhältnissen von ISO 100 bis einschließlich ISO 800 den nahezu identischen Dynamikumfang. D.h. Bilder, die in einer Serie entstehen / die in einem engen Kontext stehen, haben – wenn sie in schwierigen, wechselnden Lichtverhältnissen entstehen – die gleiche Farbanmutungen, die gleichen Tiefen. Sie gehören “mehr” zusammen. Sie sind in ihrer Reihe harmonischer und wirken als Serie ausgewogener, weil sie eben den gleichen Dynamikumfang haben.

Ich glaube, diese beiden Aspekte machen den Hauptunterschied aus. Dann kommt vielleicht hinzu, dass rein physikalisch bei ISO 100 die D800 mehr Differenzierungsvermögen in den Tiefen hat – die D4 hat mehr Differenzierungsvermögen in den Lichtern. Ab ISO 200 ist das Differenzierungsvermögen in den Tiefen ausgeglichen – die D4 behält jedoch bis zu ISO 25.600 konstant über 1 EV mehr Differenzierungsvermögen in den Lichtern. Und das bringt sie auch vom Sensor in das “fertige” Signal, weil sie eine über 1,3 (!) EV bessere Signalverarbeitung hat. Die D800 gleicht dies zumindest bei ISO 200 über ihren Auflösungsvorsprung aus. Beim Runterskalieren um eine Stufe ist sie in etwa bei der Größe eines D4 Bildes und müsste in etwa auf die gleichen Ergebnisse kommen – einen Tick besser vielleicht. Ab ISO 400+ liegt der Vorteil bei der D4. Da kommt dann zum Tragen, dass sie zwar weniger Pixel hat und damit weniger Signale erzeugen kann. Aber diese Signale sind vom Ursprung her besser differenziert und klarer und werden wesentlich besser verarbeitet zu ein-eindeutigen RAW Values.

Mein Fazit: Wer bei ISO 100 und ISO 200 unterwegs ist, fährt mit der D800 besser. Wer in wechselnden Lichtsituationen Serien macht oder mehr ISO (ISO 400+) braucht, greift besser zur D4. Die Framerates (fps 4 vs. 11) sind hier noch gar nicht berücksichtigt. Die dazu passenden Einsatzgebiete kann jeder selbst ableiten. Fest steht jedoch: die D4 ist mehr Allrounder als die D800 und vermutlich auch das robustere Arbeitstier.

D. RAW und Weißabgleich

Noch etwas zur Sensortechnologie… Um das Ergebnis gleich vorweg zu nehmen: ein kamera-seitig eingestellter Weißabgleich hat bei modernen Sensoren KEINEN Einfluss auf das RAW selbst, nur auf das im RAW eingebettete Vorschaubild und den späteren Entwicklungsprozess.

Warum ist das so? Nach dem Passieren des Tiefpass-Filter und des AA-Filter werden die durch gelassenen Photonen vom eigentlichen Sensor erfasst. Dieser ist ein analoges (!) Bauteil und funktioniert wie ein Siebfalle – für Photonen. Der einfallenden Licht wird im Erfassungsbereich eines Pixels gesiebt: die anteiligen roten Photonen werden von dem „roten“, die grünen vom grünen und die blauen vom blauen Subpixel eingefangen. Die so eingefangenen Photonen erzeugen im Subpixel einen Stromfluss. Vereinfacht gesprochen: Je mehr Photonen eingefangen wurden, je mehr Elektronen werden freigesetzt, je höher die elektrische Spannung im Subpixel. Nun erfolgt ein einfaches Messen der Spannung für jedes Subpixel im Sensor. Der jeweils erhaltene Wert ist zunächst einmal ein analoger (!) Wert.

Als nächstes greift der ISO-Verstärker in die Prozesskette ein. Der ISO-Verstärker ist ein ganz einfacher, klassischer Verstärker. Die elektrischen Spannungen der einzelnen Subpixel werden im Zuge des Messvorganges durch den ISO-Verstärker in vorgegebenen Stufen (ISO 100, 200, 400, …) verstärkt. (Über Clipping-Effekte, Rauschen etc. gehe ich an dieser Stelle hinweg.)

Der Messwert der verstärkten Spannung wird nun in einen A/D-Wandler übertragen, welcher aus der analog gemessenen Spannung eine binäre Zahl macht. Diese Zahl nennen wir den RAW Value eines Subpixels. Dieser Wert ist das, was später in der Software wieder zurückgerechnet wird in einen Farbanteil von rot, grün oder blau eines Pixels.

In der ganzen Prozesskette bis zum RAW Value spielt ein Weißabgleich (ob automatisch oder fester Wert) überhaupt keine Rolle. Dieser wird jetzt erst wichtig. Nur wenn man in JPG fotografiert, findet in der Kamera bereits die Interpretation der Farbtemperatur (im Prinzip: wann ist weiß = weiß?) statt und ein entsprechendes JPG wird aus den RAW-Daten (!) generiert und gespeichert.

Wer in RAW fotografiert, verlagert die Interpretation der RAW Daten von der Kamera in die Software des eigenen Computers. Die Kamera gibt hierzu der Software Interpretationshilfen bzw. –vorgaben mit auf den Weg. Dies sind Daten zur „richtigen“ Entwicklung des RAWs, sprich zur richtigen Interpretation der RAW Daten wie z.B. eine Information zum Weißabgleich. Die RAW Daten selbst sind völlig neutral. Der mitgegebene Hinweis zum Weißabgleich gibt nur an, ab welcher Kombination der Werte der drei Subpixel die verwendete Software das resultierende, errechnete Pixel als einen Grauwert darstellt. (von schwarz über neutral-grau bis rein-weiß) Hieraus wiederum ergeben sich die Farbverschiebungen für alle anderen im gewählten Farbraum zulässigen und darstellbaren Farben. Auf den Einfluss und die Effekte der verwendeten Farbräume und –profile möchte ich an dieser Stelle nicht eingehen. Das ist ein Thema für einen anderen Thread.

Was jetzt aber schon klar geworden sein sollte: Der Weißabgleich im RAW spielt per se überhaupt keine Rolle. Er kommt erst bei der Entwicklung des RAW zum Tragen.

Ist es also egal, ob ich mit AWB oder festen °K-Werten arbeite?

Zunächst einmal ja. Die RAW Values sind exakt die gleichen. Nicht aber die von der Kamera empfohlene Interpretationsvorgabe. Und das bedeutet, dass ich mit einem gut definierten, festen Weißabgleich direkt weiterarbeiten kann; mit einem nicht so gut definierten Weißabgleich muss ich mit den Pipetten schwarz, neutralgrau und weiß von Hand den richtigen Weißabgleich finden, genauer gesagt: erstellen und vorgeben. Mit allen Fehlern, die dabei passieren können. (z.B. habe ich ein Bild, in welchem ich partout keinen neutral-grauen Wert finde – das wird dann ein bisschen eine Fummelei)

7 Comments

Leave your reply.